Allgemeine Qualitätsmethoden

Einleitung

Allgemeine Qualitätsmethoden sind bewährte Werkzeuge des Qualitätsmanagements, um Produkt- und Prozessqualität sowohl präventiv als auch reaktiv abzusichern. In der Medizintechnik können diese Methoden in verschiedene Prozesse der Prozesslandschaft integriert werden, um die hohen geforderten Sicherheits- und Qualitätsstandards einzuhalten und regulatorische Anforderungen (z. B. ISO 13485 oder FDA Quality System Regulation) zu erfüllen. Sie ermöglichen es, Risiken frühzeitig zu erkennen, Kundenanforderungen systematisch zu berücksichtigen und robuste Prozesse zu gestalten. Normen wie ISO 9001 und branchenspezifisch ISO 13485 fordern eine systematische Risikobetrachtung, z. B. durch Methoden wie die FMEA. Im Folgenden stellen wir wichtige allgemeine Qualitätsmethoden vor, erklären deren Prinzip, nennen Vor- und Nachteile und geben jeweils ein Beispiel aus der Medizintechnik. So können Sie verstehen, wie diese Werkzeuge dazu beitragen, die Qualität Ihrer Produkte und Prozesse sicherzustellen.

Quality Function Deployment (QFD) – Kundenanforderungen umsetzen

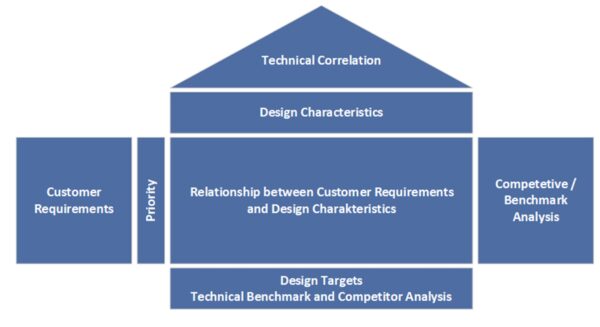

QFD ist eine Methode, um Kundenanforderungen systematisch in technische Anforderungen zu überführen. Sie wird bereits in frühen Entwicklungsphasen eingesetzt, um ein belastbares Lastenheft (Requirement-Dokument) zu erstellen. Mit QFD („House of Quality“) sammeln Sie strukturiert die Stimme des Kunden (Voice of Customer) und stellen sicher, dass Entwicklungsziele eng an den tatsächlichen Bedürfnissen von Anwendern und Patienten ausgerichtet sind. Dadurch wird verhindert, dass wichtige Anforderungen übersehen werden. Gerade in der Medizintechnik – wo Benutzerfreundlichkeit, Sicherheit und Wirksamkeit entscheidend sind – ist QFD ein wertvolles Planungswerkzeug in der Produktentwicklung. Es fördert die bereichsübergreifende Zusammenarbeit (Entwicklung, Marketing, Produktion), sodass Sie ein Produkt entwickeln, das sowohl technisch umsetzbar als auch marktorientiert ist.

Vorteile:

- Frühzeitiges Erfassen relevanter Kundenwünsche: Bereits in der Konzeptphase werden die echten Bedürfnisse der Kunden systematisch erfasst und priorisiert. Dadurch entstehen Produkte mit höherem Kundennutzen, die exakt auf die Nutzeranforderungen ausgerichtet sind.

- Abteilungsübergreifende Abstimmung: QFD bindet von Anfang an alle relevanten Abteilungen ein (Entwicklung, Produktion, Marketing). Das führt zu fertigungsgerechten Designs, verbessert die interne Kommunikation und verkürzt die Entwicklungszeit. Änderungen im späteren Verlauf werden reduziert, was Zeit und Kosten spart.

- Dokumentation und Nachvollziehbarkeit: Der Einsatz des House of Quality ergibt eine vollständig dokumentierte Matrix, welche die Entscheidungskriterien und Anforderungen transparent macht. Dies erleichtert Nachweise gegenüber Auditoren im Rahmen von Design Controls nach ISO 13485.

Nachteile / Einschränkungen:

- Aufwand und Komplexität: Die Erstellung eines House of Quality ist zeitaufwendig. Für komplexe Produkte mit sehr vielen Anforderungen kann QFD umfangreich und schwerfällig werden. Es erfordert Schulung und Moderation, damit Ihr Team die Methode effizient nutzt.

- Datenqualität entscheidend: QFD ist nur so gut wie die zugrundeliegenden Kunden-informationen. Unvollständige oder falsche Kundeninputs führen zu suboptimalen Prioritäten. Zudem muss das Team bereichsübergreifend zusammenarbeiten – fehlt die Akzeptanz, kann QFD zur reinen Formalität verkommen.

- Nicht jedes Projekt braucht QFD: Bei sehr einfachen Produkten oder geringem Innovationsgrad könnte der Nutzen von QFD den Aufwand nicht rechtfertigen.

Beispiel (Medizintechnik): Ein Entwicklerteam plant ein neues Insulinpumpen-System. Mit QFD werden zuerst die Anwenderanforderungen gesammelt – etwa „einfache Handhabung für den Patienten“, „zuverlässige Dosiergenauigkeit“ und „einfache Datenübertragung an Arztsoftware“. Diese Kundenwünsche werden im House of Quality priorisiert und technischen Merkmalen zugeordnet (z. B. Bedienoberfläche, Dosiermechanik, Wireless-Modul). So entsteht ein Lastenheft, das sicherstellt, dass die Designentscheidungen (Display-Größe, Mechanik, Softwarefunktionen etc.) konsequent an den Bedürfnissen der Stakeholder ausgerichtet sind. Das Ergebnis ist eine Insulinpumpe, die bei klinischen Tests durch Benutzerfreundlichkeit und Sicherheit überzeugt, weil nichts Wichtiges übersehen wurde.

Fehlermöglichkeits- und -einfluss-Analyse (FMEA) – Risiken vorbeugen

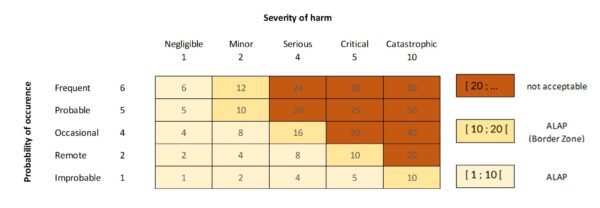

Die FMEA ist eine seit Jahren etablierte präventive Methode im Risiko- und Qualitätsmanagement. Ziel der FMEA ist es, mögliche Fehler in Produkten oder Prozessen frühzeitig zu identifizieren, deren Ursachen und Auswirkungen zu analysieren und geeignete Gegenmaßnahmen festzulegen. Schon während der Entwicklung (Design-FMEA) oder bei der Prozessplanung (Prozess-FMEA) werden Sie systematisch durch das Produkt bzw. den Prozess geführt und überlegen bei jeder Funktion oder jedem Schritt: „Was könnte hier schiefgehen, wenn das Produkt, die Komponente den Anforderungen entspricht – oder wenn es diesen nicht entspricht?“. Dabei bewerten Sie für jede potenzielle Fehlerart die Auftretenswahrscheinlichkeit, die Schwere der Auswirkung (Severity) und die Entdeckungs-wahrscheinlichkeit (letzteres ist durch die ISO 14971 nicht explizit gefordert). Das Produkt aus diesen Faktoren ist die Risikoprioritätszahl (RPZ), anhand derer priorisiert wird, wo Handlungsbedarf besteht. FMEAs werden in der Medizintechnik häufig im Rahmen des Risikomanagement-Prozesses nach ISO 14971 eingesetzt, um Anforderungen der Sicherheit und Leistungsfähigkeit zu erfüllen. Wichtig ist, dass eine FMEA erst mit der Umsetzung der Maßnahmen abgeschlossen ist – so stellen Sie sicher, dass identifizierte Risiken auch wirklich beseitigt oder zumindest so weit wie möglich reduziert wurden.

Vorteile:

- Frühe Risikoerkennung: Bereits in der Entwicklungs- oder Planungsphase entdecken Sie potenzielle Fehler und Schwachstellen, bevor sie in der Praxis auftreten. Das ermöglicht vorbeugende Maßnahmen (Designänderungen, Tests, Prozessanpassungen), was kostspielige Änderungen im Nachhinein oder Rückrufe reduziert.

- Strukturierte, teamorientierte Analyse: FMEA fördert die interdisziplinäre Teamarbeit. Verschiedene Experten (Entwickler, Qualitätsmanager, Kliniker, Fertigung) bringen ihr Wissen ein, sodass alle Einflussfaktoren betrachtet werden. Nichts wird vergessen – das Vorgehen ist nachvollziehbar und dokumentiert (wichtig für Audits).

- Priorisierung von Risiken: Durch RPZ-Bewertungen können Sie die kritischsten Risiken klar identifizieren und gezielt angehen. So wird das Team auf die wirklich sicherheitsrelevanten Probleme fokussiert, was in der Medizintechnik direkt der Patientensicherheit zugutekommt. Zudem verlangen viele Kunden oder Aufsichtsbehörden einen solchen Nachweis der Risikobewertung.

Nachteile / Einschränkungen:

- Zeit- und Ressourcenaufwendig: Eine gründliche FMEA kann sehr umfangreich werden. Für komplexe Geräte oder Prozesse sind mitunter Hunderte von möglichen Failure Modes zu analysieren. Dies erfordert viel Zeit, disziplinierte Moderation und Pflege des FMEA-Dokuments.

- Subjektivität bei Bewertungen: Die Einschätzung von Wahrscheinlichkeit und Entdeckungsrate ist teils subjektiv. Unterschiedliche Teammitglieder könnten zu unterschiedlichen RPZ kommen. Hier hilft Erfahrung und ggf. firmenweite Kriterien, doch die „Genauigkeit“ von FMEAs ist begrenzt – sie sind ein qualitatives Werkzeug.

- Begrenzte Eignung für komplexe Zusammenhänge: FMEAs betrachten in der Regel Einzelfehlerursachen und deren direkte Auswirkungen. Bei sehr komplexen Szenarien, in denen mehrere Faktoren zusammenwirken müssen, um einen Schaden zu verursachen (z. B. Anwendungsfehler plus Gerätestörung plus Umgebungsbedingungen), kann eine FMEA unübersichtlich werden oder die Verkettung mehrerer Ereignisse unzureichend abbilden. In solchen Fällen sind ergänzende Methoden wie Fehlerbaumanalyse (für Kombinationen von Ursachen) sinnvoll.

- Pflegeaufwand: Nach Produktänderungen oder Prozessanpassungen muss die FMEA aktualisiert werden. Dieser kontinuierliche Pflegeaufwand wird in der Praxis manchmal vernachlässigt.

Beispiel (Medizintechnik): Ein Hersteller entwickelt einen neuen Infusionspumpen-Controller. Im Rahmen der Design-FMEA identifiziert das Team mögliche Fehlermöglichkeiten wie „Pumpe fördert ungewollt zu viel Medikament“. Ursachen könnten ein Softwarefehler im Dosieralgorithmus, ein klemmendes Ventil oder Benutzerfehler bei der Programmierung sein. Die Auswirkungen – im schlimmsten Fall Überdosierung mit Patientenschaden – werden als sehr schwerwiegend eingestuft. Durch die FMEA findet das Team eine kritische Ursache: eine mögliche Überhitzung eines Sensors, die zu falschen Flussraten führen könnte. Dieses Risiko erhält eine hohe RPZ. Als Maßnahme wird das Design geändert (zusätzlicher Temperatursensor und Alarm bei Überhitzung). Zudem werden strenge Tests definiert. Das Ergebnis: Die Infusionspumpe wird so gestaltet, dass das identifizierte Risiko minimiert ist, und die Prüfanweisung stellt sicher, dass der Sensor zuverlässig überwacht wird. Die FMEA-Dokumentation dient anschließend auch als Nachweis gegenüber Prüflabor und Behörden, dass systematisch an die Patientensicherheit gedacht wurde.

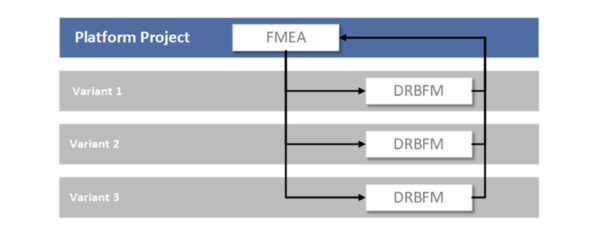

DRBFM (Design Review Based on Failure Mode) – Änderungen beherrschen

DRBFM ist eine Variante der FMEA, die sich besonders bei Änderungen an bestehenden Produkten bewährt hat. Der Grundgedanke: „Neue Risiken entstehen vor allem durch Veränderungen.“ DRBFM wurde von Toyota entwickelt und bedeutet sinngemäß „Design-Überprüfung auf Basis potenzieller Fehlerzustände“. Wenn Sie in der Medizintechnik ein bestehendes Gerät weiterentwickeln oder ein Produktupdate planen, fokussiert DRBFM gezielt auf die Änderungen: Welche neuen Failure Modes könnten dadurch entstehen? Welche bisherigen Annahmen gelten nicht mehr? DRBFM ist dabei pragmatischer und fokussierter als eine komplette FMEA des ganzen Produkts. Die Methode etabliert sich zunehmend im Qualitätsmanagement als effiziente Alternative zur klassischen FMEA bei Produktvarianten. So können Änderungen rasch, aber dennoch abgesichert implementiert werden, was z. B. für Produktverbesserungen oder Software-Updates in Medizinprodukten sehr nützlich ist.

Vorteile:

- Fokus auf Änderungen: Statt das gesamte Design erneut zu analysieren, konzentriert sich DRBFM auf die Delta-Änderungen. Das spart Zeit und Ressourcen, da bekannte, unveränderte Teile nicht nochmal komplett bewertet werden müssen.

- Schnelle Identifikation neuer Risiken: Durch gezielte Fragen (Was ist geändert? Warum? Was könnte dadurch schiefgehen?) entdecken Sie schnell die kritischen Stellen, an denen eine Änderung zu Problemen führen könnte. So bleiben auch nachträgliche Produktupdates sicher.

- Praxisnähe: DRBFM fördert offene Diskussionen im Team über die Änderungen. Ingenieure teilen ihre Annahmen und prüfen gemeinsam die Robustheit. Das führt oft zu einfachen, aber effektiven Maßnahmen, um Änderungsfehler zu verhindern (z. B. zusätzliche Tests nur für geänderte Komponenten).

- Effizienter als vollständige FMEA: Bei kleinen Änderungen wäre eine komplette FMEA übertrieben. DRBFM bietet hier ein schlankes Vorgehen, das in der Automobilindustrie schon lange Zeitdruck standhält und nun auch in anderen Branchen Anklang findet.

Nachteile / Einschränkungen:

- Nur für Änderungen geeignet: DRBFM entfaltet seinen Nutzen hauptsächlich, wenn ein bestehendes, robustes Basissystem vorliegt. Für Neuentwicklungen muss weiterhin eine reguläre FMEA gemacht werden.

- Erfahrung erforderlich: Die Methode verlangt, dass das Team das ursprüngliche Design und seine Funktionen sehr gut versteht. Nur so können die Auswirkungen der Änderungen richtig beurteilt werden. Unerfahrene Teams könnten Risiken übersehen, weil sie implizite Funktionen oder Schnittstellen nicht bedenken.

- Keine RPZ-Bewertung: Anders als FMEA verzichtet DRBFM oft auf zahlenbasierte Priorisierung. Das kann die Vergleiche der Risiken erschweren. Es erfordert Disziplin, dennoch die wichtigsten Risiken zu erkennen und nicht im Detail zu verlieren.

Beispiel (Medizintechnik): Ein Unternehmen möchte bei einem Herzschrittmacher-Modell den Batterietyp ändern, um die Laufzeit zu erhöhen. Mit DRBFM setzt sich das Entwicklungsteam zusammen und betrachtet ausschließlich, was sich durch den neuen Batterietyp ändert. Man stellt fest, dass die neue Batterie geringfügig andere Spannungscharakteristiken hat. Ein mögliches neues Fehlerbild: Bei fast leerer Batterie könnte die Spannung abrupt abfallen, was im Worst Case zu einem Ausfall der Impulsabgabe führt. Dieses Szenario war beim alten Batterietyp nicht gegeben. Als Maßnahme beschließt das Team, die Software so zu ändern, dass schon früher ein Batteriewechsel angezeigt wird (Frühwarnung) und gründliche Tests der Batterie im Gerät durchzuführen. Durch diese gezielten Bewertungen der Änderung mit DRBFM wird sichergestellt, dass der neue Batterietyp keine ungeahnten Risiken für Patienten mit sich bringt.

Messsystemanalyse (MSA) – Zuverlässige Prüfmittel sicherstellen

Eine Messsystemanalyse (MSA) untersucht, ob Ihre Prüf- und Messmittel zuverlässige, reproduzierbare Ergebnisse liefern. In der Medizintechnik hängt die Qualitätsentscheidung oft von Messwerten ab – z. B. die Dicke eines Katheters, die Ausgabedosis eines Inhalators oder elektrische Messungen an einem Gerät. MSA stellt die Eignung des Messsystems sicher, indem es Messabweichungen quantifiziert. Typische Fragen sind: Wie groß ist die Wiederholgenauigkeit (repeatability) eines Messgeräts? Wie wirkt sich der Bediener (Reproduzierbarkeit) auf das Ergebnis aus? Welche Messunsicherheit besteht insgesamt? Wenn Sie z. B. an fünf identischen Produkten messen, sollten idealerweise alle Messungen nahezu den gleichen Wert liefern – MSA deckt auf, ob dem so ist. In regulierten Branchen ist dies wichtig: ISO 13485 verlangt die Überwachung und Validierung von Prüfmitteln, und FDA erwartet, dass Entscheidungen auf valide Daten gestützt werden. Eine MSA (z. B. Durchführung einer Prüfmittelfähigkeitsuntersuchung oder Gage R&R) liefert diesen Nachweis.

Vorteile:

- Vertrauen in Messergebnisse: Durch MSA wissen Sie, ob ein Prüfsystem genau und präzise genug ist, um über Gut/Schlecht zu entscheiden. So vermeiden Sie Fehlentscheidungen – etwa das fälschliche Ausmustern guter Teile oder das Durchwinken fehlerhafter Produkte aufgrund unzuverlässiger Messungen.

- Identifikation von Messfehler-Quellen: MSA zerlegt die Gesamtstreuung in Komponenten (z. B. Bedienereinfluss, Gerätetoleranz, Umwelteinflüsse). Dadurch erkennen Sie, wo Verbesserungen ansetzen können – vielleicht braucht das Personal Schulung, oder ein Messgerät muss besser kalibriert werden.

- Regulatorische Konformität: Die Dokumentation einer MSA zeigt Auditoren, dass Ihr Unternehmen systematisch sicherstellt, dass Prüfungen aussagekräftig sind. Dies unterstützt die Forderung der ISO 13485 nach fähigen Messmitteln und ist oft Teil der Prozessvalidierung.

Nachteile / Einschränkungen:

- Zusätzlicher Aufwand: Eine formale Messsystemanalyse erfordert zahlreiche Messungen (mehrere Teile, mehrere Wiederholungen, mehrere Mitarbeiter) und statistische Auswertung. Dieser Aufwand wird im engen Projektzeitplan leicht gescheut. Allerdings ist er meist gerechtfertigt, da unzuverlässige Messungen später viel teurere Probleme verursachen können.

- Statistische Kenntnisse erforderlich: Die Auswertung (z. B. Gage R&R Studie) erfordert Verständnis von Varianzanalysen und Statistiken. Nicht jeder Qualitätsmanager ist darin bewandert, was zu Fehlinterpretationen führen kann. Entsprechende Schulung oder Softwareunterstützung ist nötig.

- Grenzfälle schwer beurteilt: MSA gibt Quantifizierung, aber die Entscheidung „Ist mein Messsystem noch akzeptabel?“ kann schwierig sein, wenn Ergebnisse grenzwertig sind. Die gängigen Richtwerte (z. B. <10% Streuung des Toleranzbereichs) sind nicht immer starr anwendbar, besonders bei engen Toleranzen in der Medizintechnik. Hier ist manchmal Engineering-Judgement gefragt.

Beispiel (Medizintechnik): In der Produktion von Blutzuckerteststreifen wird ein optisches Messgerät verwendet, um die Reaktionsfarbintensität (und damit die Glukosekonzentration) zu bestimmen. Das Qualitätsteam führt eine MSA durch, indem es dieselben Proben mehrfach von verschiedenen Mitarbeitern messen lässt. Die Analyse zeigt z. B., dass ein Operator systematisch leicht höhere Werte misst als die anderen. Ursache könnte eine unterschiedliche Handhabung des Testgeräts sein. Zudem stellt sich heraus, dass die Messgeräte selbst eine gewisse Streuung aufweisen. Insgesamt beträgt die Messunsicherheit ~15% der Toleranz – was als grenzwertig angesehen wird. Auf Basis dieser MSA-Erkenntnisse schult der Hersteller die Mitarbeiter in der einheitlichen Handhabung und lässt die Geräte neu kalibrieren. Bei einer erneuten MSA sinkt die Streuung auf 8% der Toleranz. Damit ist sichergestellt, dass die Prüfmittel zuverlässig sind und nur wirklich nicht konforme Teststreifen ausgesondert werden. Dies erhöht das Vertrauen in die Qualitätsprüfung und verhindert, dass Patienten fehlerhafte Teststreifen erhalten.

Statistische Prozesskontrolle (SPC) – Prozesse stabil in Kontrolle halten

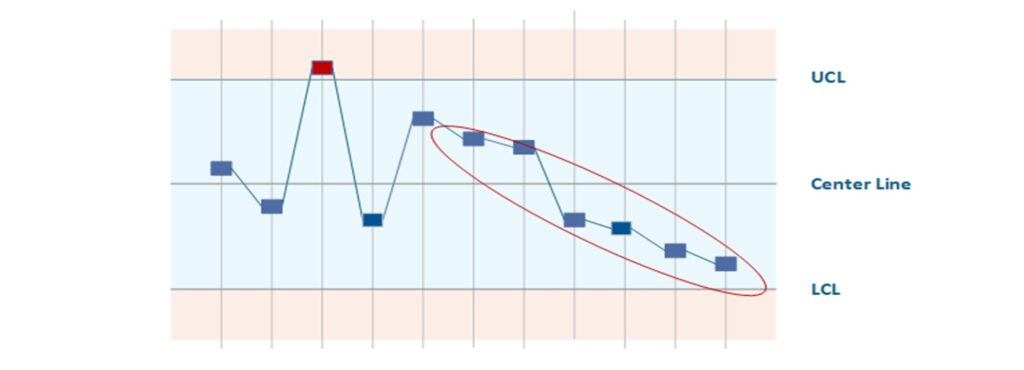

SPC (Statistical Process Control) ist eine Methodik, um laufende Fertigungsprozesse durch Statistik zu überwachen und frühzeitig Veränderungen zu erkennen. Kernelement sind Qualitätsregelkarten (Control Charts), auf denen fortlaufend Prozesskennzahlen (z. B. Maße, Gewichte, Messwerte) eingetragen werden. Sie definieren dabei obere und untere Kontrollgrenzen, die den normalen Schwankungsbereich eines beherrschten Prozesses darstellen. Erkennt SPC ein Muster oder einen Ausreißer (Punkt außerhalb der Kontrollgrenzen oder Trends), signalisiert dies, dass der Prozess potenziell außer Kontrolle gerät. Dann können Gegenmaßnahmen eingeleitet werden, bevor tatsächlich Ausschuss oder Fehler entstehen. In der Medizintechnik-Produktion – wo hohe Anforderungen an Reproduzierbarkeit bestehen (z. B. beim Sterilisationsprozess, Spritzguss von Bauteilen oder Beschichtung von Implantaten) – ist SPC ein wichtiges Werkzeug der Qualitätssicherung. Es ermöglicht kontinuierliche Prozessverbesserung (KVP) und dient als Nachweis der Prozessfähigkeiten (Cp, Cpk-Werte) gegenüber Kunden und Auditoren.

Vorteile:

- Früherkennung von Prozessdrift: SPC warnt Sie früh, wenn ein Prozess sich ungewöhnlich verhält (Trend, Ausreißer). So können Sie korrigierend eingreifen, bevor Spezifikationsgrenzen verletzt werden und Ausschuss entsteht. Das reduziert Kosten durch Nacharbeit/Rejects und erhöht die Liefertreue.

- Objektive Prozessbewertung: Anhand von Prozessfähigkeitskennzahlen (Cp, Cpk) können Sie quantitativ beurteilen, ob ein Prozess stabil und fähig ist. Dies ist gerade für qualitätskritische medizintechnische Prozesse wichtig, die validiert werden müssen.

- Nachhaltige Verbesserung: SPC visualisiert die Prozessleistung über die Zeit. Verbesserungsmaßnahmen zeigen sich direkt auf der Regelkarte – so werden Erfolge oder weiterer Handlungsbedarf sichtbar. Mitarbeiter an der Linie können durch SPC-Daten eigenverantwortlich handeln (Empowerment), was die Qualitätskultur stärkt.

Nachteile / Einschränkungen:

- Nicht für alle Prozesse geeignet: SPC setzt gewisse Stückzahlen und Datenmengen voraus. In der Medizintechnik gibt es aber auch Kleinserien oder Chargenfertigung mit geringen Stückzahlen, wo SPC statistisch wenig aussagekräftig ist. Ebenso müssen die Messwerte kontinuierlich erhoben werden können – für manche Qualitätsmerkmale (z. B. komplexe Funktionsprüfungen) ist das nicht immer praktikabel.

- Initialer Aufwand und Know-how: Die Einführung von SPC erfordert Schulung der Mitarbeiter und initialen Aufwand, um geeignete Regelkartentypen zu wählen, Messsysteme anzubinden und Auswertungen aufzusetzen. Ohne Verständnis besteht die Gefahr, dass Warnsignale ignoriert oder falsch interpretiert werden.

- Falscher Alarm vs. Trägheit: Zu eng gesetzte Kontrollgrenzen können zu häufigen „Fehlalarmen“ führen, was die Belegschaft frustriert. Zu weite Grenzen hingegen erkennen Abweichungen zu spät. Die richtige Balance muss gefunden werden. Außerdem überwacht SPC nur bekannte Merkmale – unbekannte Fehlerarten werden nicht erfasst.

Beispiel (Medizintechnik): In der Herstellung von vorgefüllten Spritzen (z. B. Heparin-Spüllösung) wird mittels SPC die Füllmenge überwacht. Jede 100. Spritze kommt auf eine Waage, und das Gewicht wird auf einer Regelkarte eingetragen. Im Laufe der Schicht zeigt die Xquer-Karte einen leichten Abwärtstrend der Füllmenge, obwohl alle Spritzen noch innerhalb der Spezifikation sind. Das SPC-System alarmiert die Schichtleitung, die umgehend eingreift: Man entdeckt, dass eine Düse der Abfüllanlage sich allmählich zusetzt. Durch Reinigung der Düse wird der Trend gestoppt. Ohne SPC wäre dieser Effekt erst bemerkt worden, wenn Spritzen unterfüllt gewesen wären (Außerhalb der Toleranz), was zu einer Ausschusscharge geführt hätte. Dank SPC blieb der Prozess in der Kontrolle, und die Qualität der Chargen konnte sichergestellt werden. Zudem nutzt das Unternehmen die SPC-Daten, um die Prozessfähigkeiten nachzuweisen und regelmäßige Prozess-Reviews durchzuführen.

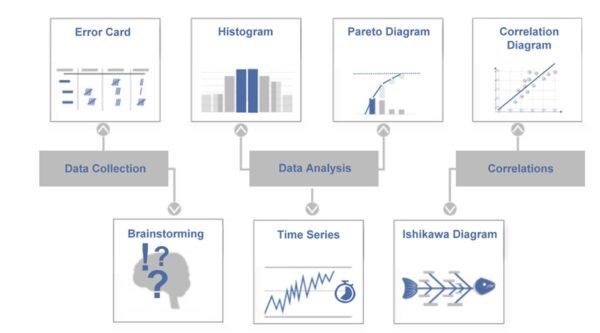

Sieben Qualitätswerkzeuge (Q7) – Basis-Werkzeugkasten der Qualität

Die 7 Qualitätswerkzeuge (Q7) sind eine traditionelle Sammlung von einfachen, aber wirkungsvollen Methoden zur Analyse und Lösung von Qualitätsproblemen. Sie gelten als Grundausstattung jedes Qualitätsingenieurs. Zu den klassischen Q7 zählen nach Ishikawa: Brainstorming, Fehlersammelliste, Qualitätsregelkarte, Ursache-Wirkungs-Diagramm, Histogramm, Korrelationsdiagramm und Pareto-Diagramm. Diese Methoden helfen, Fakten zu sammeln und darzustellen, um auf solider Basis Entscheidungen für Verbesserungsmaßnahmen zu treffen. In der Medizintechnik lassen sich die sieben Werkzeuge breit einsetzen – von der Reklamationsanalyse bis zur Produktionsoptimierung. Wichtig ist: Die Q7 sind relativ leicht erlernbar und daher auch für Einsteiger ein guter Startpunkt, um datengetrieben an Qualitätsthemen heranzugehen.

Vorteile:

- Einfach und vielseitig: Die sieben Werkzeuge sind intuitiv verständlich und benötigen meist nur Stift und Papier (bzw. einfache Software). Sie können von Ihnen praktisch sofort angewendet werden, ohne großen Aufwand. Trotz ihrer Einfachheit decken sie viele Situationen ab – vom Finden möglicher Ursachen (Fishbone) über Datenauswertung (Histogramm) bis zur Priorisierung (Pareto-Prinzip).

- Daten- und Faktenorientierung: Q7 helfen, subjektive Eindrücke durch objektive Daten zu untermauern. Z. B. zeigt ein Pareto-Diagramm schnell, welche Fehlerarten am häufigsten auftreten, sodass Verbesserungen dort ansetzen. Das erhöht die Treffsicherheit von Maßnahmen.

- Breite Bekanntheit: Da diese Tools zum Qualitäts-Einmaleins gehören, sind sie in vielen Unternehmen etabliert. Teams haben eine gemeinsame Sprache, wenn sie z. B. von „Pareto-Analyse“ sprechen. Das erleichtert bereichsübergreifende Problemlösungen.

Nachteile / Einschränkungen:

- Begrenzte Tiefe: Komplexe, multivariate Probleme lassen sich mit den einfachen 7 Tools nur teilweise erfassen. Beispielsweise zeigt ein Korrelationsdiagramm Beziehung zwischen zwei Variablen, aber keine Kausalität. Für tiefere Analysen sind dann erweiterte Methoden (wie statistische Versuchsplanung, Six Sigma Tools) nötig.

- Manuelle Anwendung kann fehleranfällig sein: Wenn Q7 händisch geführt werden, können Daten falsch erfasst oder interpretiert werden. Zudem erfordert es Disziplin, die Tools wirklich zu benutzen statt nur theoretisch zu kennen.

- Oft nur Startpunkt: Die Q7 liefern häufig Symptome und erste Ursachenhypothesen (z. B. zeigt das Fischgräten-Diagramm mögliche Ursachen, Pareto zeigt Häufigkeiten). Die eigentliche Lösungsfindung erfordert anschließend oft weitere Schritte (z. B. 5 Why oder Experimentieren), damit wirklich die Wurzel des Problems eliminiert wird.

Beispiel (Medizintechnik): Ein Qualitätsteam in einem Laborgeräte-Unternehmen untersucht häufige Ausfälle eines Zentrifugen-Geräts. Zunächst sammelt es Daten mit einer Fehlersammelliste über 3 Monate: Welche Fehlermeldungen treten auf, in welchem Bereich, wie oft? Ein Pareto-Diagramm zeigt, dass 60% der Ausfälle auf zwei Fehlertypen entfallen: „Überhitzungsalarm“ und „Unwuchtabschaltung“. Das Team erstellt daraufhin ein Ursache-Wirkungs-Diagramm (Ishikawa) für den Überhitzungsalarm und brainstormt mögliche Ursachen in den Kategorien Mensch, Maschine, Methode, Material, Milieu, Messung. Dabei identifiziert es u. a. verstopfte Lüftungsfilter (Kategorie Maschine/Umgebung) als mögliche Ursache. Eine Überprüfung bestätigt: In vielen ausgefallenen Geräten waren die Lüftungsschlitze durch Staub blockiert. Nun wird als Maßnahme ein präventives Reinigungsprogramm eingeführt und die Konstruktion der Lüftungsfilter verbessert. Dieses Beispiel zeigt, wie die Anwendung mehrerer Q7-Werkzeuge – Fehlersammeln, Pareto und Ishikawa – in Kombination schnell von einer unübersichtlichen Problemwelt zu klaren Ursachen und wirksamen Lösungen führt.

Methoden der Ursachenanalyse

Einleitung

Trotz aller präventiven Methoden lassen sich Fehler im Feld oder der Produktion nie vollständig verhindern. Ursachenanalyse-Methoden helfen Ihnen, im Fall von Problemen systematisch der Wurzel eines Fehlers auf den Grund zu gehen (Root Cause Analysis). Dies ist ein zentraler Bestandteil des CAPA-Prozesses (Corrective and Preventive Action) im medizintechnischen Qualitätsmanagement. Regulatoren wie FDA und ISO 13485 erwarten, dass Unternehmen bei Abweichungen nicht nur Symptome behandeln, sondern die wahre Fehlerursache ermitteln und beseitigen. Tatsächlich gehört unzureichende Ursachenanalyse zu den häufigsten Beanstandungen bei Audits – wenn die Ursache nicht richtig gefunden wird, sind Korrekturmaßnahmen oft wirkungslos. Die folgenden Methoden unterstützen Sie dabei, Probleme gründlich zu analysieren und nachhaltige Lösungen umzusetzen. Wir erläutern wieder Prinzip, Vor-/Nachteile und nennen Beispiele, wie diese Techniken in der Medizintechnik eingesetzt werden, um z. B. Produktionsfehler, Kundenreklamationen oder Sicherheitsvorfälle effektiv zu untersuchen.

5W1H-Methode – Problem systematisch eingrenzen

Bevor man direkt nach Ursachen gräbt, hilft die 5W1H-Methode, zunächst das Problem klar einzugrenzen. 5W1H steht für die Fragen: Who, What, Where, When, Why, How – auf Deutsch Wer? Was? Wo? Wann? Warum? Wie?. Wichtig: Hier bedeutet 5W nicht das fünfmalige „Warum?“ Fragen, sondern es sind fünf unterschiedliche W-Fragen, die gestellt werden. Durch diese Fragen sammeln Sie alle grundlegenden Informationen zu einem Vorfall, ähnlich wie ein Ermittler oder ein Unfallmelder es tun würde. Beispielsweise klären Sie: Wer hat das Problem festgestellt (und wer ist betroffen)? Was genau ist passiert (Fehlerbild)? Wo tritt es auf (Standort, Maschine, Charge)? Wann ist es zuerst/zuletzt aufgetreten (Zeitpunkt, nach welchem Ereignis)? Warum glaubt man, dass es passiert ist (erste Vermutung, Auslöser)? Und Wie wurde bisher reagiert oder könnte man es vorläufig beheben? Diese strukturierte Informationssammlung bildet den Auftakt jeder Ursachenanalyse. In vielen CAPA-Prozessen ist ein 5W1H-Formular fester Bestandteil, um sicherzustellen, dass das Problem verstanden und eingegrenzt ist, bevor Maßnahmen ergriffen werden.

Vorteile:

- Vollständiges Problemverständnis: Die 5W1H-Fragen zwingen dazu, alle Aspekte eines Problems zu beleuchten, nicht nur den technisch naheliegendsten. Dadurch gewinnen Sie ein umfassendes Bild und können Doppelarbeit oder Fehlfokussierung vermeiden.

- Einfache Anwendung: Die Fragen sind einfach und universell einsetzbar. Jeder im Team kann sie beantworten, und sie liefern schnell strukturiert dokumentierte Infos. Gerade in Stresssituationen (z. B. akuter Produktionsstopp) hilft ein solches Schema, nichts Wichtiges zu übersehen.

- Grundlage für weitere Analyse: 5W1H liefert oft schon Hinweise auf mögliche Ursachen oder zumindest darauf, wo man weitergraben sollte. Zudem dienen die Antworten als Startpunkt für Berichte – z. B. fließen sie direkt in eine 8D-Report-Beschreibung ein.

Nachteile / Einschränkungen:

- Kein direktes Finden der Ursache: 5W1H ist eine Problemdefinitions- und Eingrenzungsmethode, noch keine eigentliche Ursachenanalyse. Sie beschreibt das „Was ist passiert?“, aber nicht warum. Die eigentliche Root Cause Analysis muss im Anschluss erfolgen.

- Erfordert genaue Infos: Wenn die zur Verfügung stehenden Informationen lückenhaft oder fehlerhaft sind (z. B. meldet der Kunde nur „Gerät defekt“ ohne weitere Details), dann bleibt auch 5W1H vage. Hier muss eventuell zunächst Datenbeschaffung betrieben werden (Proben sichern, Beteiligte interviewen etc.), bevor man die Fragen beantworten kann.

- Mögliche Fehlannahmen: Bei „Warum (ist es geschehen)?“ neigt man vielleicht dazu, vorschnell eine Ursache zu vermuten. Diese erste Vermutung sollte jedoch mit Vorsicht behandelt werden – sie muss erst durch die späteren Ursachenanalyse-Methoden validiert werden, statt sie ungeprüft als Tatsache zu nehmen.

Beispiel (Medizintechnik): Ein Unternehmen erhält von einem Krankenhaus die Meldung, dass ein elektrischer Chirurgie-Pen während einer Operation ausgefallen ist. Bevor ins Labor geeilt wird, sammelt der CAPA-Manager per 5W1H die Fakten: Wer meldete den Vorfall? → OP-Leitung, erfahrene Anwenderin. Was genau geschah? → Der Pen lieferte plötzlich keine Energie mehr, LED aus. Wo? → In OP-Saal 3, Gerät Seriennr. X, Charge Y. Wann? → Nach ca. 15 Minuten Nutzungszeit, Patient war bereits in Behandlung. Warum (Vermutung)? → Möglicherweise Überhitzung oder Wackelkontakt (erste Vermutung des Technikers vor Ort). Wie wurde reagiert? → Ersatzgerät wurde eingesetzt, Patient blieb unversehrt, defektes Gerät wurde aus dem Verkehr gezogen. Mit diesen Infos startet das Team nun gezielt die Ursachenanalyse am betreffenden Gerät (Prüfung auf Überhitzungsschutz, Löten der Kontakte etc.). Das strukturierte 5W1H-Protokoll stellt sicher, dass alle Grundinfos bereitstehen und später auch der Untersuchungsbericht vollständig ist.

5-Why-Methode – Den Ursachen auf den Grund gehen

Die 5-Why-Methode (auch 5 Warum genannt) ist eine einfache Fragetechnik, um durch wiederholtes Fragen nach dem „Warum“ schrittweise von einer Problemerscheinung zur tiefer liegenden Ursache vorzudringen. Die Zahl 5 ist dabei eher Richtwert – es geht darum, so oft „Warum?“ zu fragen, bis man keine fundierte Antwort mehr hat und der Kern des Problems sichtbar wird. Diese Technik wird häufig in Kombination mit dem Ishikawa-Diagramm angewendet: Erst identifizieren Sie mögliche Ursachen (breit gefächert) und dann bohren Sie bei den wahrscheinlichen Ursachen tiefer nach. Der Charme von 5 Why liegt in seiner Simpelheit: Man braucht kein besonderes Tool außer gesundem Menschenverstand und Ehrlichkeit. In der Medizintechnik eignet sich 5 Why z. B. gut im CAPA-Prozess bei Vorfällen oder Beanstandungen, um sicherzustellen, dass man nicht an oberflächlichen Gründen hängenbleibt. Kinder sind übrigens natürliche Experten dieser Methode – sie fragen so lange „Warum?“, bis die Erwachsenen manchmal keine Antwort mehr wissen. Genauso beharrlich sollte man bei Qualitätsproblemen vorgehen.

Vorteile:

- Einfach und schnell einsetzbar: Jeder kann sofort die „5 Warum“ fragen, es braucht keine Ausbildung. Die Methode fördert ein fokussiertes Denken in Ursachenketten und kann sehr schnell Klarheit schaffen, besonders bei unkomplizierten Problemen.

- Dringt zur Kernursache vor: Durch konsequentes Weiterfragen vermeiden Sie, vorschnell Symptome zu behandeln. Stattdessen gelangen Sie oft zu prozessualen oder systemischen Schwachstellen, die das Problem ursprünglich ausgelöst haben. Das führt zu wirksameren Lösungen.

- Geringer Aufwand, dokumentierbar: 5 Why lässt sich leicht in einem CAPA-Bericht dokumentieren und nachvollziehen. Es ist ein gutes Kommunikationsmittel, um Führungskräften oder Auditoren zu zeigen, dass man methodisch zum Root Cause vorgedrungen ist.

Nachteile / Einschränkungen:

- Linearität: 5 Why betrachtet in der Regel eine Ursache-Wirkungs-Kette in die Tiefe. Viele Probleme – gerade in komplexen medizintechnischen Systemen – haben aber mehrere Faktoren. Wenn man nur einen Pfad verfolgt, besteht die Gefahr, andere (mit-)Ursachen zu übersehen. Daher sollte 5 Why bei komplexen Fällen immer mit einer breit angelegten Ursachenfindung (Ishikawa, Datenanalyse) kombiniert werden.

- Abhängig vom Wissen der Beteiligten: Die Antworten auf die Warum-Fragen müssen aus dem Team kommen. Wenn Wissen oder Ehrlichkeit fehlen (z. B. „Warum ist der Test fehlgeschlagen?“ – „Weil der Mitarbeiter unaufmerksam war.“ – diese Antwort kann voreilig oder unvollständig sein), kommt man eventuell nicht zur wahren Ursache. Es braucht manchmal mehr als 5 Fragen und evtl. Messungen/Untersuchungen, um zur faktischen Ursache zu gelangen statt bei Annahmen zu bleiben.

- Keine quantitative Gewichtung: 5 Why liefert qualitativ die Ursache, aber nicht unbedingt eine Priorität. Bei mehreren gefundenen Ursachen hilft die Methode nicht zu entscheiden, welche am kritischsten oder häufigsten ist – dafür wären ergänzende Analysen (z. B. Pareto) nötig.

Beispiel (Medizintechnik): In einer Sterilgut-Abfüllung wurde zuletzt eine höhere Keimbelastung festgestellt. Das Team nutzt 5 Why: Warum sind Keime im Produkt? → Weil der Sterilfilter Bakterien durchließ (Befund im Labor). Warum ließ der Filter Bakterien durch? → Weil er beschädigt war. Warum war er beschädigt? → Weil beim Einbau der Filter falsch gehandhabt wurde und ein feiner Riss entstand. Warum kam es zu dieser falschen Handhabung? → Weil die Mitarbeiter keine spezifische Schulung zum neuen Filtersystem hatten. Warum gab es keine Schulung? → Weil im Änderungsprozess versäumt wurde, eine Schulung anzustoßen (Systemlücke). Durch diese Fragenkette erkennt das Unternehmen, dass die eigentliche Ursache nicht einfach „ein defekter Filter“ war, sondern ein Prozessfehler im Schulungs-/Änderungsmanagement. Die CAPA-Maßnahme zielt nun darauf ab, die Schulungsprozesse zu verbessern und sicherzustellen, dass bei technischen Änderungen automatisch Trainings erfolgen. Zusätzlich werden natürlich alle defekten Filter ausgetauscht. Hier hat 5 Why geholfen, über den Tellerrand des ersten technischen Defekts hinauszublicken und einen systemischen Verbesserungsbedarf aufzudecken.

Pareto-Analyse – Fokussieren auf das Wesentliche

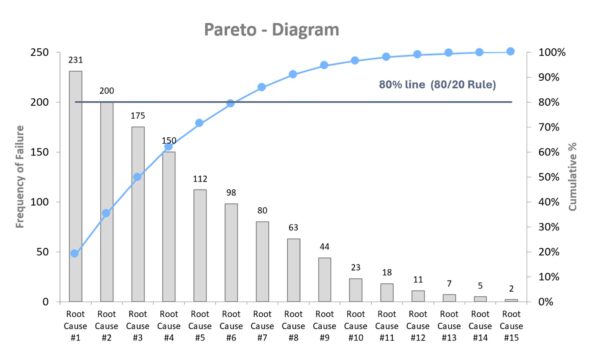

Die Pareto-Methode, auch als 80/20-Regel bekannt, ist eine einfache, aber äußerst wirkungsvolle Methode zur Priorisierung von Problemen oder Ursachen. Sie basiert auf dem Prinzip, dass in vielen Fällen ein kleiner Teil der Ursachen einen Großteil der Wirkungen ausmacht – z. B. 20 % der Fehlerarten verursachen 80 % der Reklamationen. Diese Erkenntnis geht zurück auf den italienischen Ökonomen Vilfredo Pareto und wurde später von Qualitätsguru Joseph Juran in den Qualitätsbereich übertragen. Die Methode besteht typischerweise darin, eine Häufigkeitsanalyse von Fehlerarten oder Ursachen durchzuführen und diese in einem Pareto-Diagramm (Säulendiagramm mit kumulierter Kurve) darzustellen (Siehe nachfolgende Grafik). Sie erkennen dadurch auf einen Blick, welche Probleme oder Fehlerarten den größten Beitrag zum Qualitätsmangel leisten – und können Ihre Ressourcen gezielt auf diese konzentrieren. In der Medizintechnik eignet sich die Pareto-Analyse hervorragend, um z. B. Reklamationsdaten, Ausfallgründe oder Nichtkonformitäten in Audits zu analysieren und gezielt die größten Hebel zu identifizieren.

Vorteile:

- Fokus auf das Wesentliche: Statt sich mit allen Fehlerarten gleichzeitig zu beschäftigen, zeigt die Pareto-Analyse, welche wenigen Ursachen den Großteil der Probleme verursachen. Das spart Zeit und Ressourcen und sorgt dafür, dass Sie dort ansetzen, wo es den größten Nutzen bringt.

- Einfach, schnell und visuell: Die Methode ist leicht verständlich und erfordert nur grundlegende Daten und Excel oder ein ähnliches Tool. Das Pareto-Diagramm ist visuell eingängig und eignet sich sehr gut, um vor Management oder in Teammeetings schnell Entscheidungsgrundlagen zu präsentieren.

- Basis für weitere Analyse: Die identifizierten „Pareto-Spitzenreiter“ können anschließend mit anderen Methoden (z. B. Ishikawa, 5 Why) tiefergehend untersucht werden. So schafft Pareto eine fundierte Priorisierung der Ursachenanalyse.

- Sehr breit einsetzbar: Ob Sie Ausfälle, Kundenreklamationen, Auditabweichungen oder Prüfmerkmalsverletzungen analysieren – überall dort, wo Datenhäufigkeiten vorliegen, bringt die Pareto-Analyse schnell Klarheit.

Nachteile / Einschränkungen:

- Nur Häufigkeit, keine Schwere: Pareto zeigt an, was oft passiert – nicht, was besonders gefährlich oder teuer ist. Eine seltene, aber kritische Abweichung (z. B. lebensbedrohlicher Produktausfall) kann unter dem Radar bleiben, wenn man sich nur auf Pareto verlässt. Daher sollten Sie bei sicherheitskritischen Themen stets auch Risiko und Auswirkung betrachten (z. B. ergänzend zur FMEA).

- Datenqualität entscheidend: Die Aussagekraft hängt stark von der Klassifikation und Genauigkeit der Eingangsdaten ab. Wenn Fehlerarten zu grob oder inkonsistent erfasst wurden, kann die Analyse verzerrt sein. Die Erhebung und Kategorisierung muss diszipliniert erfolgen, um aussagekräftige Ergebnisse zu erzielen.

- Nicht für kleine Datenmengen: Bei sehr wenigen Fällen (z. B. unter 10) ist die Pareto-Analyse wenig hilfreich – hier ist eher eine Einzelfallanalyse (z. B. 5 Why) angebracht. Pareto funktioniert am besten mit größeren Stichproben, aus denen sich Trends ableiten lassen.

Beispiel (Medizintechnik): In einem Unternehmen, das elektronische Patientenüberwachungsgeräte herstellt, häufen sich Servicefälle. Das Qualitätsmanagement sammelt alle Beanstandungen des letzten Jahres und kategorisiert sie: „Akkulaufzeit zu kurz“, „Software-Freeze“, „Display-Ausfall“, „Fehlalarm bei Herzfrequenz“ etc. Die Häufigkeiten werden erfasst und in einem Pareto-Diagramm dargestellt. Die Analyse ergibt: 3 von 12 Fehlerarten verursachen 78 % aller Servicefälle – allen voran der Display-Ausfall (Rissbildung durch mechanische Belastung beim Transport). Das Team fokussiert sich nun auf diese Hauptursachen, startet eine Ursachenanalyse (5 Why, Design Review) und findet heraus: Die Displays waren unzureichend gegen Stöße geschützt. Eine Designänderung am Gehäuse und neue Transportvorgaben lösen das Problem. Die Folgereklamationen sinken drastisch. Ohne die Pareto-Analyse hätte man möglicherweise versucht, alle Fehler gleichzeitig zu lösen – und dabei viel Aufwand an untergeordnete Probleme verschwendet. Hier zeigt sich: Wer Pareto nutzt, arbeitet klüger, nicht härter.

Ursache-Wirkungs-Diagramm (Ishikawa) – Ursachen systematisch sammeln

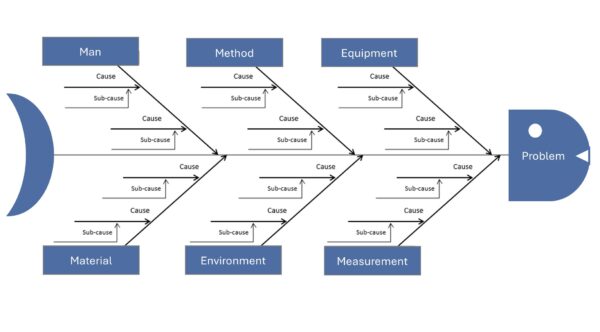

Das Ishikawa-Diagramm, auch Fischgräten- oder Ursache-Wirkungs-Diagramm genannt, ist ein grafisches Tool, um mögliche Ursachen für ein Problem in Kategorien zu sammeln. Es wurde vom Japaner Kaoru Ishikawa entwickelt und klassisch in Form einer Fischgräte gezeichnet: Der „Kopf“ des Fisches ist das Problem (Wirkung), die Hauptgräten sind typische Ursachenkategorien (z. B. Mensch, Maschine, Methode, Material, Milieu, Messung – oft die „6 M“). An diesen Hauptgräten werden alle denkbaren Ursachen als Nebenäste notiert(siehe dazu die nachfolgende Abbildung). Die Methode fördert Ihre Teammitglieder, kreativ und umfassend nach möglichen Fehlerquellen zu suchen, ohne vorschnell etwas auszuschließen. In der Medizintechnik bietet sich das Ishikawa-Diagramm etwa bei komplexen Problemen an, wo viele Faktoren eine Rolle spielen könnten (z. B. unklare Testergebnisse, sporadische Geräteausfälle, Prozessschwankungen). Durch die Visualisierung werden vorhandenes Wissen und auch Wissenslücken sichtbar. Oft wird das Ishikawa-Diagramm mit Brainstorming erstellt – mittlerweile auch gerne mit Software (Mindmapping), um es übersichtlicher zu machen.

Vorteile:

- Strukturierte und umfassende Ursachenfindung: Das Fischgräten-Diagramm leitet Sie an, systematisch in Kategorien zu denken, sodass keine Dimension (Mensch, Technik, Umwelt etc.) vergessen wird. Das führt zu einer schnellen und breiten Eingrenzung möglicher Fehlerursachen.

- Visualisierung fördert Verständnis: Alle Teammitglieder sehen auf einen Blick die gesammelten Ideen und deren Zusammenhänge. Das schafft ein gemeinsames Verständnis des Problems und deckt auch Wissenslücken auf (wenn z. B. bei einer Kategorie kaum jemand etwas beitragen kann).

- Einfaches Ableiten von Maßnahmen: Hat man die möglichen Ursachen identifiziert, können zu den vielversprechendsten bereits ersten Gegenmaßnahmen oder Prüfungen abgeleitet werden. Die Darstellung macht klar, wo man mit Priorität ansetzen sollte.

- Gut kombinierbar mit anderen Methoden: Ishikawa ist oft Startpunkt der Analyse. Die vielversprechendsten Äste werden danach z. B. mit 5 Why vertieft oder mittels Datenanalyse geprüft. Dadurch bietet das Diagramm einen flexiblen Rahmen für weitere Ursachenforschung.

Nachteile / Einschränkungen:

- Nicht automatisch Gewichtung oder Beweis: Das Diagramm sammelt mögliche Ursachen, aber es sagt nicht, welche tatsächlich die Hauptursache ist. Ohne anschließende Verifikation (z. B. Experimente, Daten) besteht die Gefahr, dass man sich auf eine falsch vermutete Ursache stürzt oder eine wichtige übersieht.

- Komplexität bei sehr großen Problemen: Wenn ein Problem viele mögliche Einflussgrößen hat, kann das Ishikawa-Diagramm sehr verzweigt und unübersichtlich werden. Dann verliert es an Nutzen. Hier hilft es, ggf. zuerst mit 5W1H das Problem einzugrenzen oder große Diagramme in Teilprobleme zu splitten.

- Qualität hängt vom Teamwissen ab: Die Methode setzt voraus, dass das Team den Prozess und die Einflussfaktoren gut kennt. Bei völlig neuen oder unbekannten Prozessen (z. B. neuartige Technologien) kann das Brainstorming lückenhaft sein. In solchen Fällen stößt Ishikawa allein an Grenzen – bei hartnäckigen, länger ungelösten Problemen müssen oft erweiterte Analysen (z. B. AFD, Versuchsplanung) hinzugezogen werden.

- Darstellung muss gepflegt werden: Gerade bei handschriftlicher Erstellung am Whiteboard kann das Ergebnis unleserlich oder chaotisch sein, vor allem wenn viele Notizen hinzukommen. Dann ist es ratsam, auf digitale Mindmaps umzusteigen, um Lesbarkeit und Dokumentation sicherzustellen.

Beispiel (Medizintechnik): In der Produktion von Dialysegeräten kommt es gelegentlich vor, dass Geräte beim End-of-Line-Test durchfallen, weil eine Druckprüfung nicht bestanden wird (leichtes Leck). Die Ingenieure erstellen ein Ishikawa-Diagramm mit dem Effekt „Leckage im Drucktest“ am Fischkopf. Als Hauptkategorien nutzen sie die 6 M: Mensch, Maschine, Methode, Material, Milieu, Messung. Unter Material finden sie mögliche Ursachen wie Dichtungsring fehlerhaft oder Schlauchmaterial porös. Unter Methode kommt falsches Anzugsdrehmoment bei Montage hinzu. Milieu (Umgebung) bringt Temperaturschwankungen ins Spiel, Messung die Möglichkeit eines undichten Testaufbaus. Nach der Brainstorming-Session hat das Team ~15 plausible Ursachen gesammelt. Nun priorisieren sie: Sie bemerken z. B., dass alle Leck-Geräte in Schicht B gefertigt wurden (Mensch). Das lenkt Aufmerksamkeit auf die Montagekräfte – tatsächlich stellt sich heraus, dass ein Mitarbeiter in Schicht B das Drehmoment nicht konsequent mit dem Schraubendreher prüfte. Die Schraubverbindungen an einem Anschluss waren oft zu locker. Damit war die Ursache gefunden: durch Nachschulung des Mitarbeiters und Einführung eines zweiten Prüfschritts (Vier-Augen-Prinzip beim Drehmoment) konnten künftige Leckagen vermieden werden. Ohne das Ishikawa-Diagramm hätte man vielleicht vorschnell auf Materialfehler getippt – doch die systematische Betrachtung enthüllte die wahre Ursache im Prozess.

Fault Tree Analysis (FTA) – Logische Fehlerbäume für komplexe Ursachen

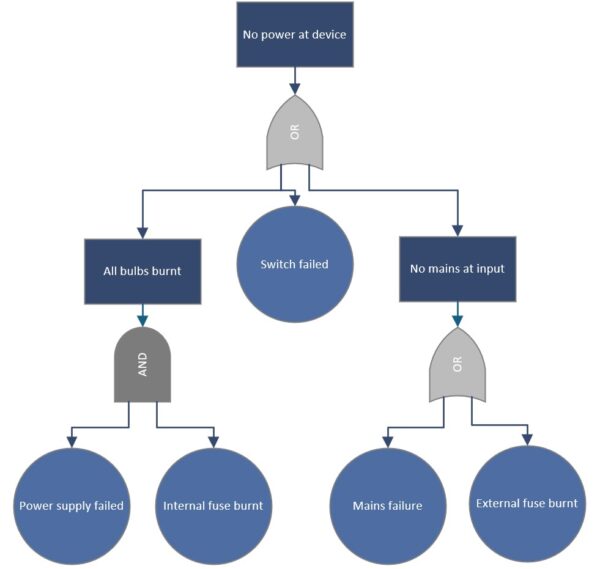

Die Fehlerbaumanalyse (FTA) ist eine deduktive Methode, um von einem beobachteten Problem (Top-Ereignis) alle Kombinationen von Ursachen logisch herzuleiten, die zu diesem Problem führen können. Im Gegensatz zum breiten Ishikawa-Ansatz, der Ursachen einfach auflistet, baut FTA eine grafische Baumstruktur auf: Oben steht das unerwünschte Ereignis (z. B. „Gerät fällt aus“), darunter verzweigen logische Gatter (UND/ODER) auf sub-Ereignisse, die gemeinsam das Top-Ereignis verursachen könnten. FTA wird häufig in sicherheitskritischen Bereichen eingesetzt, da man damit auch Wahrscheinlichkeiten berechnen kann, sofern man Ausfallraten der Grundereignisse kennt. In der Medizintechnik ist FTA z. B. in der Norm IEC 60812 als anerkannte Risikoanalyse-Methode genannt. Sie eignet sich, um multikausale Zusammenhänge zu analysieren – etwa: „Gerätealarm ertönt nicht, obwohl Fehler vorliegt“ könnte mehrere gleichzeitige Ausfälle voraussetzen, die man im Fehlerbaum modelliert. FTA wird oft top-down nach einem Zwischenfall eingesetzt, kann aber auch präventiv (als Fault Tree in der Designphase für hochkritische Funktionen) genutzt werden, ähnlich einer umgekehrten FMEA.

Vorteile:

- Gründliche Analyse komplexer Fehlerkombinationen: FTA zwingt dazu, systematisch alle logischen Pfade aufzudecken, die zu einem Top-Fehler führen. Dadurch werden auch ungewöhnliche Kombinationen sichtbar, die man mit simplerem Brainstorming übersehen könnte. Das ist besonders wertvoll, wenn mehrere unabhängige Ausfälle zusammentreffen müssen (Common Cause Analysis).

- Quantifizierung möglich: Hat Ihr Unternehmen Ausfalldaten oder Zuverlässigkeitskennzahlen, kann FTA die Ausfallwahrscheinlichkeit des Top-Ereignisses berechnen. So lässt sich zeigen, ob ein Risiko akzeptabel ist oder ob zusätzliche Sicherheitsmaßnahmen nötig sind. Diese Quantifizierung (z. B. Errechnung einer Gesamtausfallrate pro 10^6 Stunden) ist oft für Zulassungen und Sicherheitsnachweise erforderlich.

- Visuelles, logisches Modell: Der Fehlerbaum ist ein klares Diagramm, das auch fachfremden Stakeholdern (Management, Auditoren) erklärt, was für eine Verkettung an Fehlern nötig ist, damit ein schlimmer Unfall passiert. Es hilft, Diskussionen zu versachlichen („Hier sehen Sie – nur wenn zwei unabhängige Sensoren gleichzeitig ausfallen, passiert X“).

- Ergänzt FMEA bei systemischen Risiken: Während FMEA einzelfehlerorientiert ist, deckt FTA systemische Zusammenhänge ab. Beide in Kombination geben ein sehr vollständiges Bild der Risiken.

Nachteile / Einschränkungen:

- Aufwendig bei großen Systemen: Ein vollständiger Fehlerbaum für ein komplexes Medizingerät kann extrem groß werden, mit hunderten Basisereignissen. Das ist arbeitsintensiv und erfordert Sorgfalt, um korrekt und aktuell zu bleiben. Kleine Designänderungen können einen Baumabschnitt obsolet machen – die Pflege ist anspruchsvoll.

- Benötigt tiefe Systemkenntnis: Um einen sinnvollen Fehlerbaum aufzubauen, müssen Sie das Systemverhalten und mögliche Ausfallmodi sehr gut verstehen. Es besteht sonst die Gefahr, falsche Annahmen zu machen oder relevante Pfade nicht zu berücksichtigen. Die Methode verlangt also erfahrene Experten und oft interdisziplinäre Zusammenarbeit (Hardware, Software, Mechanik, Clinical).

- Wahrscheinlichkeiten nicht immer verfügbar: Gerade bei neuen Geräten haben Sie vielleicht keine belastbaren Ausfallraten der Komponenten. Die Quantifizierung beruht dann auf Schätzungen, was die Aussagekraft einschränkt. Außerdem kann FTA nur so gut sein, wie die Eingangsdaten – seltene gemeinsame Ursachen (z. B. Überspannung die zwei Systeme zugleich schädigt) sind schwer zu modellieren.

- Primär reaktiv oder für gezielte Top-Ereignisse: FTA geht von einem definierten Top-Fehler aus. Für eine allgemeine Ursachenfindung ohne klares Ausgangsproblem ist sie nicht so geeignet (da ist Ishikawa schneller). FTA ist daher meist etwas, was nach einem Unfall/Fehler eingesetzt wird oder für vorab definierte kritische Events (z. B. „Patientenschaden durch Strahlungsüberdosis“).

Beispiel (Medizintechnik): Ein Hersteller von Defibrillatoren führt eine FTA durch, nachdem in einem Zwischenfall ein Gerät den Schock nicht abgab und ein Patientenschaden gerade noch verhindert werden konnte. Top-Ereignis: „Defibrillation schlägt fehl, kein Schock“. Im Fehlerbaum darunter verzweigen u. a.: Elektronikfehler ODER Benutzerfehler ODER Batterie leer. Den Elektronikzweig brechen die Ingenieure weiter runter: Elektronikfehler könnte verursacht sein durch Kondensator defekt UND Diagnosesoftware erkennt es nicht (beide müssten zusammen auftreten, also ein UND-Gatter). Den Benutzerfehler-Zweig fächert man auf in Elektroden falsch geklebt ODER Bedienprozedur nicht eingehalten. So entsteht ein umfassendes Bild aller Möglichkeiten. Die Analyse zeigt z. B., dass die Wahrscheinlichkeit, dass sowohl Kondensatorausfall und Erkennungssoftware-Versagen zusammenkommen, extrem gering ist. Häufiger ist das Szenario „Batterie leer und niemand hat es bemerkt“. Daraufhin implementiert der Hersteller eine lautere Batteriealarm-Funktion und schult Anwender, vor jeder Schicht die Batterie zu prüfen. Durch die FTA konnte man sowohl technische als auch menschliche Faktoren systematisch untersuchen und gezielt vorbeugen, dass der schlimme Top-Fehler künftig auftritt.

Shainin-Methode – Statistische Ursachenfindung im Prozess

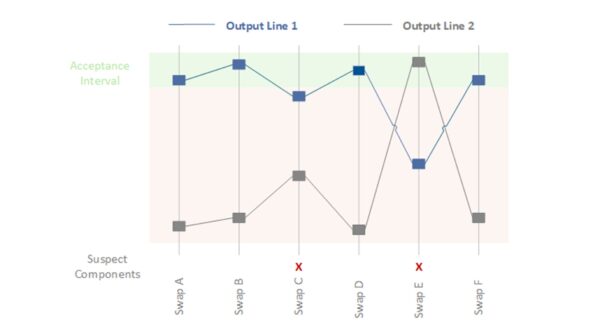

Die Shainin-Methode (nach Dorian Shainin) oder auch Homing-In-Technik ist ein pragmatischer Werkzeugkasten zur Ursachenanalyse, der insbesondere in der Prozessoptimierung eingesetzt wird. Shainin folgt dem Prinzip „lass die Daten sprechen“ und zielt darauf ab, mit minimalem Aufwand die Hauptursache (die „Red X“) eines Qualitätsproblems zu finden. Statt von vornherein alle möglichen Ursachen gleichwertig zu behandeln, isoliert Shainin schrittweise die signifikanteste Einflussgröße. Typische Techniken sind z. B. Komponenten-F swaps (systematisches Austauschen von Teilen zwischen Gut- und Schlecht-Teilen, um den verursachenden Part zu finden) oder Multi-Vari-Analysen (Statistikauswertung der Streuung innerhalb/zwischen und über Zeit). Die Stärke der Shainin-Methode liegt darin, dass Sie nicht umfangreiche theoretische Modelle brauchen, sondern direkt am realen Prozess experimentieren können, bis die Ursache eingegrenzt ist. In der Medizintechnik kann Shainin etwa bei Prozessproblemen helfen, z. B. wenn Fertigungslose stark schwankende Ergebnisse zeigen und klassische Ursachenfindung erfolglos blieb. Auch im Gesundheitswesen (Krankenhausprozesse) wurde Shainin bereits angewandt, um z. B. Ursachen für medizinische Fehler oder ineffiziente Abläufe zu finden.

Vorteile:

- Schnelle Fokussierung auf Hauptursache: Durch systematisches „Homing-in“ auf die Red X identifizieren Sie oft mit vergleichsweise wenigen Versuchen den größten Übeltäter im Prozess. Das spart Ressourcen, weil man nicht alle Faktoren bis ins Detail untersuchen muss, sondern rasch herausfiltert, was wirklich zählt.

- Anwenderfreundlich und praxisnah: Die Shainin-Tools sind relativ einfach zu verstehen und anzuwenden, selbst ohne tiefgehende Statistikkenntnisse. Dadurch werden sie auf dem Shopfloor gut akzeptiert. Man arbeitet direkt am praktischen Problem mit realen Daten, was oft zielführender ist als theoretische Analysen.

- Geringe Datenanforderung: Im Gegensatz zu klassischen Six-Sigma-Ansätzen, die umfangreiche Datenmengen und vollfaktorielle Versuchspläne nutzen, kommen bei Shainin wenige gezielte Experimenten oder Vergleichen zum Einsatz. Das ist besonders in der Medizintechnik hilfreich, wo manchmal nur begrenzte Stichproben verfügbar sind.

- Fokus und Geschwindigkeit: Indem man sich auf eine Variable nach der anderen konzentriert (z. B. durch Paarvergleiche, „Was ist anders zwischen Gut und Schlecht?“), gelangt man oft in Tagen zu Lösungen, wo konventionelle Methoden Wochen bräuchten. Shainin wird daher gern genutzt, um akute Fertigungsprobleme schnell in den Griff zu bekommen.

Nachteile / Einschränkungen:

- Begrenzung auf einzelne Hauptursache: Die Methode neigt dazu, eine dominierende Ursache zu suchen. Bei sehr komplexen Problemen mit mehreren vergleichbar starken Einflussfaktoren kann Shainin an Grenzen stoßen oder eine weniger dominante, aber wichtige Ursache übersehen.

- Erfahrung und Fingerspitzengefühl nötig: Obwohl Shainin-Tools einfach sind, braucht es ein gutes Verständnis des Prozesses, um die richtigen Vergleichs-Strategien zu wählen. Weniger erfahrene Anwender könnten falsche Schlüsse ziehen, wenn sie z. B. Störfaktoren nicht kontrollieren.

- Nicht immer formal anerkannt: In stark regulierten Umfeldern möchte man manchmal statistisch fundiertere Nachweise (p-Werte, Konfidenzintervalle). Shainin liefert pragmatische Ergebnisse, aber kritische Auditoren könnten tieferes Zahlenmaterial einfordern. Manchmal wird Shainin intern genutzt, um die Ursache zu finden, und dann ein formelles DoE (Design of Experiments) nachgereicht, um die Kausalität zu belegen.

- Change Management: Die Einführung der Shainin-Philosophie kann auf Widerstand stoßen, wenn die Organisation stark auf traditionelle Ansätze fixiert ist. Es erfordert Management-Support, damit Teams offen sind für diesen anderen Problemlösungsansatz.

Beispiel (Medizintechnik): Zwei Fertigungslinien für Blutbeutel verzeichnen variable Schweißnahtfestigkeiten – einige Beutel der einen Linie platzen im Belastungstest, die der anderen Linie halten viel aus. Die übliche Ursachenanalyse (Ishikawa, 5 Why) brachte keine klare Ursache zutage, weil viele Faktoren infrage kamen (Materialcharge, Schweißtemperatur, Anpressdruck, Kühlzeit etc.). Nun greift man zur Shainin-Methode: Man nimmt einige „gute“ (haltbare) und „schlechte“ (undichte) Beutel und beginnt mit Paarvergleichen. Zuerst tauscht man systematisch das Foliematerial zwischen der guten und schlechten Linie, um zu sehen, ob das Problem mitwandert – nein, Material scheint nicht der Red X. Dann untersucht man die Schweißwerkzeuge: Man schickt einen erfahrenen Techniker von der guten Maschine zur schlechten Maschine (Mensch-Faktor) – keine Änderung; aber als man die Schweißmatrize (Werkzeug) von der guten auf die schlechte Anlage wechselt, verbessern sich die Ergebnisse der schlechten Anlage deutlich. Bingo – der Hauptverursacher (Red X) ist die Schweißmatrize bzw. ihr Zustand. Genauere Untersuchung zeigt feine Riefen auf der Kontaktfläche der problematischen Matrize, was zu ungleichmäßiger Hitzeverteilung führte. Durch Austausch bzw. Überarbeitung der Matrize wird das Problem behoben. Die Shainin-Strategie („systematisches Austauschen und Eingrenzen“) hat hier in kurzer Zeit die Ursache offengelegt, während man mit breit gestreuten Analysen vielleicht deutlich länger gebraucht hätte.

Deltalyze – Schnelle Problemlösung à la Daimler

Deltalyze ist eine spezielle Problemlösungsmethode, die von der Daimler AG entwickelt wurde. Der Name leitet sich von „Delta“ (Unterschied) ab. Im Grunde genommen verfolgt Deltalyze ein ähnliches Ziel wie Shainin: Möglichst schnell die Fehlerursache eingrenzen, indem man die Unterschiede zwischen funktionierenden und fehlerhaften Einheiten analysiert. Deltalyze kombiniert dabei strukturierte Fragebögen, Datenanalysen und expertenbasiertes Troubleshooting. Außerhalb von Daimler ist diese Methode weniger verbreitet; jedoch kann man den Ansatz – Konzentration auf Unterschiede – auch in anderen Branchen nachvollziehen. In der Medizintechnik gibt es keine bekannte standardisierte Deltalyze-Methode, aber Firmen nutzen ähnliche Prinzipien intern. Beispielsweise könnte man bei einem Gerätefehler gezielt fragen: „Was unterscheidet die fehlerhaften Geräte von den guten?“ (andere Charge, andere Bediener, anderer Zulieferer, etc.) und daraus Hypothesen ableiten. Deltalyze steht hier stellvertretend für Best-Practice-Problemlösungen, die große Unternehmen entwickeln, um in Reklamationsfällen effizienter zu werden.

Vorteile:

- Fokus auf Unterschiede: Deltalyze lenkt sofort Aufmerksamkeit auf das, was anders ist, wenn der Fehler auftritt. Das beschleunigt die Ursachenfindung erheblich, da man nicht im Nebel aller Möglichkeiten stochert, sondern konkret Variation untersucht.

- Praxisbewährt: Bei Daimler wurde Deltalyze offenbar so erfolgreich eingesetzt, dass es als eigene Methodik benannt wurde. Es vereint erprobte Tools (z. B. 5 Why, Datenanalyse) in einem Ablauf. Für Medizintechnikfirmen kann es inspirierend sein, eigene Troubleshooting-Standards zu entwickeln, die ähnlich schnell wirken.

- Team-Einbindung: Methoden wie Deltalyze setzen oft auf moderierte Workshops mit Experten, um rasch Wissen zusammenzutragen. Das stärkt das Problemlösungsdenken im Team und sorgt dafür, dass jeder relevante Unterschied beleuchtet wird.

Nachteile / Einschränkungen:

- Proprietär und wenig dokumentiert: Außerhalb des Konzerns ist wenig detaillierte Anleitung verfügbar. Firmen müssten ihren eigenen Prozess ausarbeiten. Ohne klaren Leitfaden läuft man Gefahr, Deltalyze nur als Buzzword zu verwenden – die Effektivität hängt also von der konkreten Umsetzung ab.

- Braucht vergleichbare Fälle: Die Idee „Unterschiedsanalyse“ funktioniert nur, wenn man tatsächlich ausreichend Vergleichsdaten hat – also fehlerhafte versus fehlerfreie Fälle. Bei einzigartigen Problemen (ein einmaliger Vorfall ohne Vergleich) greift dieser Ansatz nicht gut.

- Keine Wunderlösung: Letztlich nutzt auch Deltalyze bekannte Werkzeuge, nur strukturiert. Wenn Teams schon gut mit 8D, Shainin etc. arbeiten, bringt Deltalyze als neuer Name allein keinen Mehrwert. Schlimmer, es könnte Verwirrung stiften, wenn man plötzlich eine neue Methode propagiert, die im Kern das gleiche tut.

Beispiel (Medizintechnik): Angenommen, ein Hersteller von Hörgeräten hat in einer bestimmten Charge ungewöhnlich viele Ausfälle kurz nach Auslieferung. Ein internes „Deltalyze“-ähnliches Team wird gebildet. Sie vergleichen defekte mit intakten Hörgeräten und stellen fest: Alle defekten stammen aus derselben Produktionswoche und wurden von einer neuen Liefercharge eines Mikro-Lötzinns gefertigt. Funktionierende Geräte wurden entweder früher produziert oder mit dem alten Lötzinn. Hier sticht ein Delta ins Auge – das Lötmaterial. Weitere Untersuchung bestätigt: Das neue Lötzinn hatte Verunreinigungen, die kalte Lötstellen verursachten. Die Firma zieht die Charge zurück und wechselt zum bewährten Material. Dieses fiktive Beispiel zeigt, wie die Konzentration auf Unterschiede (Zeit, Liefercharge) rasch zur Ursache führen kann. In der Praxis hätte man das auch mit klassischen Methoden entdecken können, aber ein formalisiertes Vorgehen wie Deltalyze hätte das Team gezielt darauf gestoßen, nach solchen Unterschieden zu suchen.

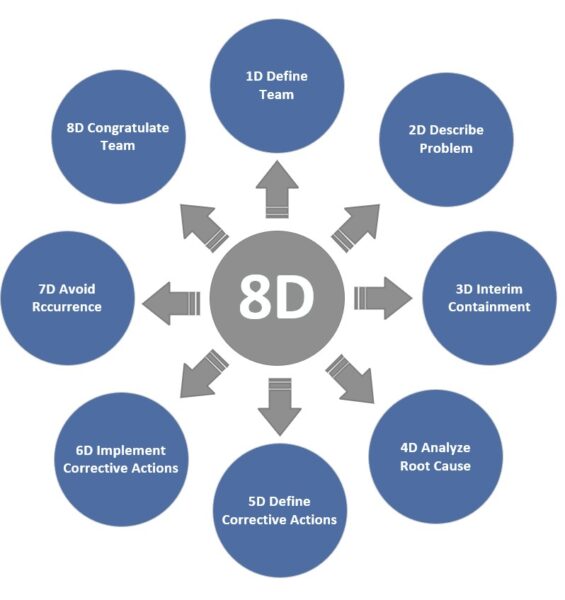

8D-Report – Strukturierter Team-Prozess zur Problembehebung

Die 8D-Methode (Eight Disciplines) ist ein standardisierter 8-Schritte-Prozess zur Problemlösung, der vor allem im Reklamationsmanagement eingesetzt wird. Ein 8D-Report führt Sie und Ihr Team durch alle wichtigen Disziplinen: von der Teamzusammenstellung (D1) über Problembeschreibung (D2) und Sofortmaßnahmen (D3) hin zu Ursachenanalyse (D4), Abstellmaßnahmen (D5), Wirksamkeitsprüfung (D6) und Präventionsmaßnahmen (D7), bis der Abschluss (D8 – Team würdigen) erfolgt. Dieser ganzheitliche Ansatz stellt sicher, dass nicht nur die technische Ursache gefunden, sondern auch das Umfeld betrachtet wird – z. B. werden temporäre Maßnahmen ergriffen, um den Kunden sofort zu schützen, und es wird geprüft, ob ähnliches anderswo passieren könnte. In der Medizintechnik ist 8D zwar nicht vorgeschrieben, aber viele Firmen nutzen es analog zu CAPA, da es eine saubere Dokumentation und vorgegebene Denkschritte bietet. Im Automotive-Bereich ist der 8D-Report oft Pflicht bei Zulieferer-Reklamationen, was dessen Verbreitung auch in andere Branchen gefördert hat.

Vorteile:

- Systematik und Vollständigkeit: Die 8D-Methode stellt sicher, dass Ihr Team nichts Wesentliches vergisst. Insbesondere die Trennung von Sofortcontainment (D3) und permanenter Abstellung (D5) sowie die explizite Wirksamkeitskontrolle (D6) entsprechen Best Practices im CAPA-Prozess. Dieser strukturierte Ablauf reduziert die Gefahr, vorschnell „abzuhaken“, ohne dass die Ursache wirklich behoben ist.

- Teamorientierung: 8D betont die Bildung eines interdisziplinären Teams (D1). Das fördert die Zusammenarbeit und nutzt kollektives Wissen. Probleme werden nicht isoliert von Einzelpersonen bearbeitet, sondern gemeinschaftlich – was oft zu kreativeren Lösungen führt.

- Dokumentation und Kommunikation: Ein ausgefüllter 8D-Report dient als klarer Kommunikationsbericht an Kunden, Management oder Aufsichtsbehörden. Er zeigt transparent auf, wie das Problem angegangen wurde. Gerade in der Medizintechnik kann ein solider 8D-Bericht im Audit nach ISO 13485 hilfreich sein, um die Wirksamkeit des CAPA-Prozesses zu demonstrieren.

- Nachhaltigkeit: Durch Schritt D7 (Vorbeugemaßnahmen) wird geprüft, wie das Gelernte auf ähnliche Prozesse/Produkte übertragen werden kann, um Wiederholfehler auch an anderer Stelle zu verhindern. Diese Lessons Learned erhöhen die langfristige Qualität.

Nachteile / Einschränkungen:

- Zeit- und Dokumentationsaufwand: Kritiker merken an, dass der 8D-Prozess bei kleineren Problemen mit geringem Risiko überdimensioniert sein kann. Das Ausfüllen des Reports und Durchlaufen aller Schritte kostet Zeit. Für jede Kleinigkeit ein volles 8D zu verlangen, kann eine Organisation auch lähmen. Daher sollte die Methode auf mittelgroße bis große Probleme fokussiert werden, während Bagatellen evtl. schlankerer Behandlung bedürfen.

- Erfordert Training und Disziplin: Ein 8D ist nur so gut wie seine Umsetzung. Ohne Schulung füllen Teams den Report mit Plattitüden oder springen Schritte. Beispielsweise wird manchmal D4 (Ursachenanalyse) unzureichend gemacht, was dazu führt, dass die gewählte Abstellmaßnahme ins Leere geht. Es braucht Qualitätskultur, um 8D gewissenhaft durchzuziehen.

- Nicht 100% deckungsgleich mit CAPA-Anforderungen: Interessanterweise gibt es geringfügige Unterschiede zwischen dem klassischen 8D-Ablauf und regulatorischen Erwartungen. Zum Beispiel sieht 8D eine Verifizierung der Korrektur vor deren Implementierung vor (Schritt D5->D6), während FDA/ISO verlangen, die Wirksamkeit nach Implementation zu verifizieren. Das heißt, wer strikt nach 8D arbeitet, muss darauf achten, auch die formalen CAPA-Vorgaben (z. B. 21 CFR 820.100) einzuhalten. In der Praxis lässt sich das aber leicht angleichen, indem man den 8D-Prozess entsprechend auslegt.

Beispiel (Medizintechnik): Bei einem Hersteller von Kathetern häufen sich Kundenreklamationen: Einige Chargen haben Undichtigkeiten. Das Unternehmen startet einen 8D-Prozess. D1: Ein Team wird gebildet (Qualitätsingenieur, Prozessingenieur, Materialexperte, Vertriebsvertreter). D2: Problem wird beschrieben: „20% der Katheter aus Charge X und Y fallen beim Dichtigkeitstest durch – Leck an Verbindungsstück.“ D3: Sofortmaßnahme – betroffene Chargen werden gesperrt, Kunden erhalten Ersatz aus anderen Chargen; eine 100%-Prüfung wird für aktuelle Produktion eingeführt, um kein undichtes Produkt auszuliefern. D4: Ursachenanalyse – Ishikawa-Diagramm und 5 Why zeigen, dass ein neues Klebstoffgemisch verwendet wurde; offenbar passt dessen Viskosität nicht zum automatischen Dosiersystem, wodurch zu wenig Kleber aufgetragen wurde → Verbindungsstück undicht. D5: Abstellmaßnahmen – Produktionsumstellung zurück auf alten Klebstoff bzw. Anpassung der Dosieranlage; zudem werden Prozessparameter optimiert und ein zusätzlicher Dichtheits-Onlinetest installiert. D6: Wirksamkeitsprüfung – Nach Umsetzung der Maßnahmen werden mehrere Chargen produziert und vollständig geprüft: keine Leckagen mehr gefunden. Auch nach 3 Monaten zeigt sich, dass die Reklamationsrate auf 0 sank. D7: Vorbeugung – Das Team dokumentiert das Gelernte: bei Materialwechseln künftig gründlichere Validierung und Klebertests; Aufnahme einer spezifischen Prüfprozedur für Kleberauftrag in Wartungsplan. Diese Änderungen fließen ins QM-System ein. D8: Team würdigen – Die Mitglieder werden für ihren Einsatz bedankt, und die Ergebnisse werden in der nächsten Qualitätssitzung präsentiert. Dieser 8D-Report wird dem benachrichtigten OEM-Kunden und ggf. der Behörde vorgelegt, um zu zeigen: Wir haben das Problem umfassend gelöst. Durch die 8D-Methode konnte der Hersteller strukturiert, nachvollziehbar und erfolgreich das Qualitätsproblem angehen und nachhaltig abstellen.

Anticipatory Failure Determination (AFD) – Andersherum zum Kern

AFD ist eine innovative Problemlösungstechnik, die auf der TRIZ-Methode basiert und einen ungewöhnlichen Ansatz verfolgt: „umgekehrtes Denken“ bzw. die Sichtweise eines Saboteurs einzunehmen. Anstatt sich zu fragen „Warum ist der Fehler passiert?“, fragt man: „Wie könnte ich absichtlich genau diesen Fehler herbeiführen?“. Durch dieses provokative Vorgehen werden auch ungewöhnliche Ursachenhypothesen sichtbar, insbesondere bei komplexen oder lange ungelösten Problemen. AFD hilft sowohl bei der Aufdeckung von verborgenen Fehlerursachen als auch bei der Fehlerprävention für Neuentwicklungen. Die Methode ist noch relativ neu und in der Automobilindustrie bekannt, findet aber zunehmend Beachtung. In der Medizintechnik könnte AFD z. B. zum Einsatz kommen, wenn ein Gerät ein schwer erklärbares Fehlerbild zeigt, das mit normalen Analysen nicht gefunden wird – hier könnte man versuchen, kreativ destruktiv zu denken. Ebenso kann in der Produktentwicklung AFD helfen, potenzielle Missbräuche oder Fehlanwendungen früh zu identifizieren, indem man bewusst „Sabotageszenarien“ durchspielt.

Vorteile:

- Findet unorthodoxe Ursachen: Durch die Saboteur-Perspektive denkt Ihr Team „out of the box“. Man kommt auf Ursachen, die sonst nicht betrachtet würden (weil „niemand würde das absichtlich tun“). Gerade bei komplexen Problemen, die sich hartnäckig jeder Lösung entziehen, kann dieser Wechsel der Denkrichtung plötzlich den Durchbruch bringen.

- Kombiniert Ursachenanalyse mit Prävention: Indem man überlegt, wie man einen Fehler provozieren kann, identifiziert man gleichzeitig Schwachstellen im System, die man präventiv verbessern kann. Es ist also doppelt nützlich: zur Fehleraufklärung und zur Fehlervermeidung in einem.

- Stimuliert Kreativität und Teamgeist: AFD-Workshops können fast spielerisch sein – man schlüpft in die Rolle eines „bösen Genies“. Das nimmt manchmal die Frustration aus festgefahrenen Problemanalysen und motiviert das Team, neue Wege zu gehen. Zudem fördert es ein tiefes Systemverständnis, weil man das Produkt bewusst kaputtzudenken versucht.

Nachteile / Einschränkungen:

- Benötigt TRIZ-Expertise: AFD entstammt der TRIZ-Denkweise (Theorie erfinderischer Problemlösung). Nicht jeder ist mit solchen Kreativitätstechniken vertraut. Es kann anfänglich Coaching brauchen, damit das Team sich auf das „verkehrte Denken“ einlässt und das Vorgehen versteht.

- Gefahr der Unwirklichkeit: Manche Sabotage-Ideen können sehr konstruiert sein. Man muss nach der Ideenfindung die Ergebnisse kritisch bewerten: Ist diese Ursache realistisch oder nur theoretisch? Es besteht die Gefahr, Zeit auf sehr abwegige Pfade zu verwenden. Eine Balance zwischen Kreativität und Faktenbasis ist wichtig.

- Noch wenig verbreitet: Da AFD kein Standard in regulierten Branchen ist, fehlt oft das organisatorische Buy-in. Ein Qualitätsmanager muss ggf. überzeugen, warum man diese Methode einsetzt. Dokumentationen nach AFD sind nicht so etabliert wie z. B. 8D-Berichte – man muss die Erkenntnisse dann in klassische CAPA-Dokumente übertragen.

Beispiel (Medizintechnik): Ein neuartiges Laboranalysegerät zeigt sporadisch extreme Ausreißer in den Ergebnissen, die sich niemand erklären kann. Das Team probiert AFD: „Wie könnten wir absichtlich solche falschen Ergebnisse erzeugen?“. Ein Saboteur im Team meint: „Ich würde unbemerkt eine starke Magnetquelle neben das Gerät stellen, um die Sensoren zu stören.“ – Das bringt die Ingenieure auf die Idee, dass elektromagnetische Störfelder eine Rolle spielen könnten. Weitere Sabotage-Ideen: „Ich würde die Probe verunreinigen“ (Kontamination) oder „die Temperatur drastisch ändern“. Man stellt in Tests fest, dass tatsächlich eine bestimmte Laborumgebung (direkt neben einem großen Kühlsystem) magnetische Störfelder erzeugt. Normal hätte niemand vermutet, dass das Gerät, obwohl es EMV-geprüft war, so etwas abbekommt – doch genau an dem Laborstandort war die Kombination ungünstig. Durch AFD hat man letztlich entdeckt, dass elektromagnetische Interferenz die Ursache war. Die Lösung besteht darin, das Gerät besser abzuschirmen und im Labor anders zu platzieren. Dieses Beispiel verdeutlicht, wie das absichtliche „Schlechtdenken“ auf eine bislang unerkannte Ursache gelenkt hat, die man mit Standardsuche vielleicht nicht gefunden hätte.

Zusammenfassung

Abschließend lässt sich sagen: Qualitätsmethoden und Ursachenanalyse-Tools sind essenzielle Bausteine im Werkzeugkasten eines Medizintechnik-Unternehmens. Allgemeine QM-Methoden wie FMEA, SPC oder QFD helfen, Qualität von vornherein einzuplanen und zu überwachen, während Ursachenanalyse-Methoden wie 5 Why, Ishikawa, 8D & Co. sicherstellen, dass Sie aus Fehlern systematisch lernen und Dauerlösungen finden. Viele dieser Methoden ergänzen sich gegenseitig – kein Werkzeug ist ein Allheilmittel. Entscheidend ist, die passende Methode zur richtigen Zeit zu wählen und konsequent anzuwenden. Dann erfüllen Sie nicht nur die Normanforderungen (ISO 13485/FDA QSR) an ein wirksames Qualitätsmanagement, sondern schaffen auch echten Mehrwert: Sichere, zuverlässige Medizinprodukte und stabile Prozesse, auf die Sie und Ihre Kunden vertrauen können.